Annuncio pubblicitario

Negli ultimi mesi potresti aver letto la copertura circostante un articolo, scritto da Stephen Hawking, discutendo i rischi associati all'intelligenza artificiale. L'articolo ha suggerito che l'IA potrebbe rappresentare un serio rischio per la razza umana. Hawking non è solo lì - Elon Musk e Peter Thiel sono entrambi personaggi pubblici intellettuali che hanno espresso preoccupazioni simili (Thiel ha investito oltre $ 1,3 milioni nella ricerca del problema e delle possibili soluzioni).

La copertura dell'articolo di Hawking e dei commenti di Musk è stata, per non dire troppo fine, un po 'gioviale. Il tono è stato molto 'Guarda questa cosa strana di cui tutti questi geek sono preoccupati.' Poco viene data all'idea che se alcune delle persone più intelligenti sulla Terra ti avvertono che qualcosa potrebbe essere molto pericoloso, potrebbe valere la pena ascoltarlo.

Questo è comprensibile: l'intelligenza artificiale che sta conquistando il mondo suona sicuramente molto strana e non plausibile, forse a causa dell'enorme attenzione già data a questa idea dalla fantascienza scrittori. Quindi, cosa ha spaventato così tanto queste persone nominalmente sane e razionali?

Che cos'è l'intelligenza?

Per parlare del pericolo dell'intelligenza artificiale, potrebbe essere utile capire cos'è l'intelligenza. Per comprendere meglio il problema, diamo un'occhiata a un'architettura di intelligenza artificiale giocattolo utilizzata da ricercatori che studiano la teoria del ragionamento. Questo AI giocattolo si chiama AIXI e ha una serie di proprietà utili. I suoi obiettivi possono essere arbitrari, si adattano bene alla potenza di calcolo e il suo design interno è molto pulito e diretto.

Inoltre, puoi implementare versioni semplici e pratiche dell'architettura che possono fare cose del genere gioca a Pacman, se vuoi. AIXI è il prodotto di un ricercatore di intelligenza artificiale di nome Marcus Hutter, probabilmente il principale esperto di intelligenza algoritmica. È lui che parla nel video qui sopra.

AIXI è sorprendentemente semplice: ha tre componenti principali: allievo, progettista, e funzione utile.

- Il allievo accetta stringhe di bit che corrispondono all'input sul mondo esterno e cerca tra i programmi per computer fino a trovare quelli che producono le sue osservazioni come output. Questi programmi, insieme, gli consentono di indovinare come sarà il futuro, semplicemente eseguendo ciascuno di essi programma in avanti e ponderazione della probabilità del risultato in base alla durata del programma (un'implementazione di Occam Rasoio).

- Il progettista cerca tra le possibili azioni che l'agente potrebbe intraprendere e utilizza il modulo del discente per prevedere cosa accadrebbe se prendesse ciascuna di esse. Quindi li classifica in base a quanto sono buoni o cattivi i risultati previsti e sceglie il corso di azione che massimizza la bontà del risultato atteso moltiplicata per la probabilità attesa di raggiungendolo.

- L'ultimo modulo, il funzione utile, è un semplice programma che contiene una descrizione di un futuro stato del mondo e calcola un punteggio di utilità per esso. Questo punteggio di utilità indica quanto sia positivo o negativo tale risultato e viene utilizzato dal pianificatore per valutare il futuro stato mondiale. La funzione di utilità può essere arbitraria.

- Nel loro insieme, questi tre componenti formano un ottimizzatore, che ottimizza per un obiettivo particolare, indipendentemente dal mondo in cui si trova.

Questo semplice modello rappresenta una definizione di base di un agente intelligente. L'agente studia il suo ambiente, ne costruisce modelli e quindi utilizza quei modelli per trovare il corso d'azione che ne massimizzerà le probabilità ottenendo ciò che desidera. AIXI è simile nella struttura a un'intelligenza artificiale che gioca a scacchi o ad altri giochi con regole note - tranne per il fatto che è in grado di dedurre le regole del gioco giocandoci, a partire da zero conoscenze.

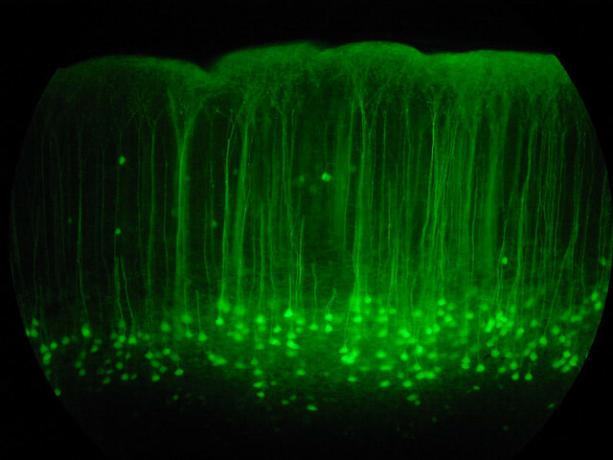

AIXI, dotato di tempo sufficiente per il calcolo, può imparare a ottimizzare qualsiasi sistema per qualsiasi obiettivo, per quanto complesso. È un algoritmo generalmente intelligente. Nota che questa non è la stessa cosa che avere un'intelligenza simile all'uomo (l'IA di ispirazione biologica è un argomento completamente diverso Giovanni Idili di OpenWorm: Brains, Worms e Artificial IntelligenceSimulare un cervello umano è una via d'uscita, ma un progetto open source sta prendendo i primi passi vitali, simulando la neurologia e la fisiologia di uno degli animali più semplici conosciuti dalla scienza. Leggi di più ). In altre parole, AIXI può essere in grado di superare in astuzia qualsiasi essere umano in qualsiasi compito intellettuale (con sufficiente potenza di calcolo), ma potrebbe non essere consapevole della sua vittoria Macchine pensanti: ciò che la neuroscienza e l'intelligenza artificiale possono insegnarci sulla coscienzaLa costruzione di macchine e software artificialmente intelligenti può insegnarci sul funzionamento della coscienza e sulla natura della mente umana stessa? Leggi di più .

Come AI pratico, AIXI ha molti problemi. Innanzitutto, non ha modo di trovare quei programmi che producono l'output a cui è interessato. È un algoritmo a forza bruta, il che significa che non è pratico se non hai un computer arbitrariamente potente in giro. Qualsiasi implementazione effettiva di AIXI è necessariamente un'approssimazione e (oggi) generalmente abbastanza approssimativa. Tuttavia, AIXI ci dà una visione teorica di come potrebbe apparire una potente intelligenza artificiale e come potrebbe ragionare.

Lo spazio dei valori

Se hai fatto qualsiasi programmazione per computer Nozioni di base sulla programmazione al computer 101 - Variabili e tipi di datiDopo aver introdotto e parlato un po 'della programmazione orientata agli oggetti prima e dove ha preso il nome viene da, ho pensato che fosse tempo di passare attraverso le basi assolute della programmazione in uno specifico non linguistico modo. Questo... Leggi di più , sai che i computer sono odiosamente, pedantici e meccanicamente letterali. La macchina non sa né si preoccupa di ciò che vuoi che faccia: fa solo ciò che gli è stato detto. Questa è una nozione importante quando si parla di intelligenza artificiale.

Con questo in mente, immagina di aver inventato una potente intelligenza artificiale: ti sei inventato con algoritmi intelligenti per generare ipotesi corrispondenti ai tuoi dati e per generare un buon candidato piani. La tua IA può risolvere problemi generali e può farlo in modo efficiente su hardware per computer moderno.

Ora è il momento di scegliere una funzione di utilità, che determinerà quali valori AI. Cosa dovresti chiedere di valutare? Ricorda, la macchina sarà odiosamente, pedanticamente letterale su qualunque funzione le chiedi di massimizzare, e non si fermerà mai - non c'è fantasma in la macchina che si "sveglia" e deciderà di cambiare la sua funzione di utilità, indipendentemente da quanti miglioramenti di efficienza apporta alle proprie ragionamento.

Eliezer Yudkowsky in questo modo:

Come in tutta la programmazione per computer, la sfida fondamentale e la difficoltà essenziale di AGI è che se scriviamo il codice sbagliato, l'intelligenza artificiale non controllerà automaticamente il nostro codice, segnerà gli errori, capirà cosa intendevamo veramente dire e farlo anziché. I non programmatori a volte immaginano che un AGI, o programmi per computer in generale, sia analogo a un servitore che segue gli ordini senza dubbio. Ma non è che l'IA lo sia assolutamente obbediente al suo codice; piuttosto, l'IA semplicemente è il codice.

Se stai cercando di far funzionare una fabbrica e dici alla macchina di valorizzare la produzione di graffette e quindi dargli il controllo di un gruppo di robot di fabbrica, tu potrebbe tornare il giorno successivo per scoprire che si è esaurito ogni altra forma di materia prima, ucciso tutti i tuoi impiegati e fatto graffette resti. Se, nel tentativo di correggere il tuo torto, riprogrammi la macchina per rendere semplicemente tutti felici, potresti tornare il giorno successivo per trovarlo che mette i fili nel cervello delle persone.

Il punto qui è che gli umani hanno molti valori complicati che presumiamo siano condivisi implicitamente con altre menti. Diamo valore al denaro, ma diamo più valore alla vita umana. Vogliamo essere felici, ma non vogliamo necessariamente mettere fili nel cervello per farlo. Non sentiamo il bisogno di chiarire queste cose quando diamo istruzioni ad altri esseri umani. Non è possibile fare questo tipo di ipotesi, tuttavia, quando si progetta la funzione di utilità di una macchina. Le migliori soluzioni sotto la matematica senz'anima di una semplice funzione di utilità sono spesso soluzioni che gli esseri umani chiedono per essere moralmente orripilanti.

Consentire a una macchina intelligente di massimizzare un'ingenua funzione di utilità sarà quasi sempre catastrofico. Come dice il filosofo di Oxford Nick Bostom,

Non possiamo assumere allegramente che una superintelligenza condividerà necessariamente uno dei valori finali associati stereotipicamente alla saggezza e sviluppo intellettuale nell'uomo: curiosità scientifica, benevola preoccupazione per gli altri, illuminazione spirituale e contemplazione, rinuncia all'acquisibilità materiale, al gusto per la cultura raffinata o per i semplici piaceri della vita, l'umiltà e l'altruismo, e così via.

A peggiorare le cose, è molto, molto difficile specificare l'elenco completo e dettagliato di tutto ciò che la gente apprezza. Ci sono molte sfaccettature alla domanda e dimenticare anche una sola è potenzialmente catastrofico. Anche tra quelli di cui siamo a conoscenza, ci sono sottigliezze e complessità che rendono difficile annotarle come sistemi puliti di equazioni che possiamo dare a una macchina come funzione di utilità.

Alcune persone, leggendo questo, concludono che la creazione di AI con funzioni di utilità è un'idea terribile, e dovremmo semplicemente progettarli in modo diverso. Qui ci sono anche brutte notizie: puoi dimostrarlo, formalmente qualsiasi agente che non ha qualcosa di equivalente a una funzione di utilità non può avere preferenze coerenti a proposito del futuro.

Auto-miglioramento ricorsivo

Una soluzione al dilemma di cui sopra è quella di non dare agli agenti di intelligenza artificiale l'opportunità di ferire le persone: dare loro solo le risorse di cui hanno bisogno risolvi il problema nel modo in cui intendi risolverlo, supervisionalo attentamente e tienilo lontano dalle opportunità di fare grandi cose danno. Sfortunatamente, la nostra capacità di controllare macchine intelligenti è altamente sospetta.

Anche se non sono molto più intelligenti di noi, esiste la possibilità per la macchina di "bootstrap" - raccogliere hardware migliore o apportare miglioramenti al proprio codice che lo rende ancora più intelligente. Ciò potrebbe consentire a una macchina di scavalcare l'intelligenza umana di molti ordini di grandezza, superando in astuzia gli umani nello stesso senso in cui gli umani superano in astuzia i gatti. Questo scenario è stato proposto per la prima volta da un uomo di nome I. J. Bene, che ha lavorato al progetto di analisi delle cripte di Enigma con Alan Turing durante la seconda guerra mondiale. La chiamò "Esplosione di intelligenza" e descrisse la questione in questo modo:

Lascia che una macchina ultra-intelligente sia definita come una macchina che può superare di gran lunga tutte le attività intellettuali di qualsiasi uomo, per quanto intelligente. Poiché la progettazione di macchine è una di queste attività intellettuali, una macchina ultra-intelligente potrebbe progettare macchine ancora migliori; ci sarebbe quindi senza dubbio una "esplosione di intelligenza" e l'intelligenza dell'uomo sarebbe lasciata molto indietro. Pertanto, la prima macchina ultra-intelligente è l'ultima invenzione che l'uomo deve mai fare, a condizione che la macchina sia abbastanza docile.

Non è garantito che un'esplosione di intelligence sia possibile nel nostro universo, ma sembra probabile. Col passare del tempo, i computer diventano più veloci e le conoscenze di base sull'intelligenza si accumulano. Ciò significa che il fabbisogno di risorse per fare l'ultimo salto verso un generale, l'intelligenza che si manifesta cala sempre più in basso. Ad un certo punto, ci ritroveremo in un mondo in cui milioni di persone possono guidare a un Best Buy e ritirare l'hardware e la letteratura tecnica di cui hanno bisogno per costruire un'intelligenza artificiale che si auto-migliora, che abbiamo già stabilito potrebbe essere molto pericoloso. Immagina un mondo in cui potresti creare bombe atomiche con bastoni e rocce. Questo è il tipo di futuro di cui stiamo discutendo.

E, se una macchina fa quel salto, potrebbe rapidamente superare la specie umana in termini intellettuali produttività, risolvendo problemi che un miliardo di umani non può risolvere, allo stesso modo in cui gli umani possono risolvere problemi che a miliardi di gatti non possono.

Potrebbe sviluppare potenti robot (o bio o nanotecnologie) e ottenere relativamente rapidamente la capacità di rimodellare il mondo come preferisce, e ci sarebbe ben poco da fare al riguardo. Un'intelligenza del genere potrebbe spogliare la Terra e il resto del sistema solare per i pezzi di ricambio senza troppi problemi, nel suo cammino verso qualsiasi cosa gli dicessimo. Sembra probabile che un tale sviluppo sarebbe catastrofico per l'umanità. Un'intelligenza artificiale non deve essere dannosa per distruggere il mondo, semplicemente catastroficamente indifferente.

Come dice il proverbio, "La macchina non ti ama o non ti odia, ma sei fatto di atomi che può usare per altre cose."

Valutazione e mitigazione del rischio

Quindi, se accettiamo che progettare una potente intelligenza artificiale che massimizzi una semplice funzione di utilità sia un male, in quanti problemi ci troviamo davvero? Quanto tempo abbiamo prima che diventi possibile costruire quel tipo di macchine? Naturalmente è difficile da dire.

Gli sviluppatori di intelligenza artificiale lo sono facendo progressi. 7 siti Web sorprendenti per vedere le ultime novità nella programmazione di intelligenza artificialeL'intelligenza artificiale non è ancora HAL del 2001: The Space Odyssey... ma ci stiamo avvicinando terribilmente. Abbastanza sicuro, un giorno potrebbe essere simile ai potboilerers di fantascienza sfornati da Hollywood ... Leggi di più Le macchine che costruiamo e i problemi che possono risolvere sono cresciuti costantemente nel campo di applicazione. Nel 1997, Deep Blue poteva giocare a scacchi a un livello superiore a quello di un grande maestro umano. Nel 2011, Watson di IBM è stato in grado di leggere e sintetizzare abbastanza informazioni in modo sufficientemente profondo e rapido da battere il miglior essere umano i giocatori in una partita a domande aperte e risposta piena di giochi di parole e giochi di parole - sono molti i progressi in quattordici anni.

In questo momento, Google lo è investendo pesantemente nella ricerca del deep learning, una tecnica che consente la costruzione di potenti reti neurali costruendo catene di reti neurali più semplici. Tale investimento gli sta permettendo di compiere seri progressi nel riconoscimento vocale e delle immagini. La loro acquisizione più recente nell'area è una startup di Deep Learning chiamata DeepMind, per la quale hanno pagato circa $ 400 milioni. Come parte dei termini dell'accordo, Google ha accettato di creare un comitato etico per garantire che la sua tecnologia AI sia sviluppata in modo sicuro.

Allo stesso tempo, IBM sta sviluppando Watson 2.0 e 3.0, sistemi in grado di elaborare immagini e video e argomentare per difendere le conclusioni. Hanno fornito una semplice e iniziale demo della capacità di Watson di sintetizzare argomenti a favore e contro un argomento nella demo video qui sotto. I risultati sono imperfetti, ma comunque un passo impressionante.

Nessuna di queste tecnologie è pericolosa in questo momento: l'intelligenza artificiale come campo sta ancora lottando per abbinare le abilità dominate dai bambini piccoli. La programmazione informatica e la progettazione dell'IA sono un'abilità cognitiva molto difficile e di alto livello e saranno probabilmente l'ultimo compito umano in cui le macchine diventano competenti. Prima di arrivare a quel punto, avremo anche macchine onnipresenti che può guidare Ecco come arriveremo in un mondo pieno di automobili senza conducenteLa guida è un'attività noiosa, pericolosa ed esigente. Potrebbe un giorno essere automatizzato dalla tecnologia automobilistica senza conducente di Google? Leggi di più , pratica medicina e diritto, e probabilmente anche altre cose, con profonde conseguenze economiche.

Il tempo che ci vorrà per arrivare al punto di inflessione di auto-miglioramento dipende solo dalla velocità con cui abbiamo buone idee. La previsione di progressi tecnologici di questo tipo è notoriamente difficile. Non sembra irragionevole che potremmo essere in grado di costruire una forte intelligenza artificiale tra vent'anni, ma non sembra irragionevole che potrebbero volerci ottanta anni. Ad ogni modo, alla fine accadrà e c'è motivo di credere che quando accadrà, sarà estremamente pericoloso.

Quindi, se accettiamo che questo sarà un problema, cosa possiamo fare al riguardo? La risposta è assicurarsi che le prime macchine intelligenti siano sicure, in modo che possano avviarsi fino a un livello significativo di intelligenza e quindi proteggerci dalle macchine non sicure prodotte in seguito. Questa "sicurezza" è definita dalla condivisione dei valori umani e dalla volontà di proteggere e aiutare l'umanità.

Poiché non possiamo effettivamente sederci e programmare i valori umani nella macchina, probabilmente sarà necessario progettare una funzione di utilità che richiede alla macchina di osserva gli umani, deduci i nostri valori e poi cerca di massimizzarli. Al fine di rendere sicuro questo processo di sviluppo, può anche essere utile sviluppare intelligenze artificiali specificamente progettate non avere preferenze sulle loro funzioni di utilità, permettendoci di correggerle o spegnerle senza resistenza se iniziano a smarrirsi durante lo sviluppo.

Molti dei problemi che dobbiamo risolvere per costruire un'intelligenza artificiale sicura sono difficili matematicamente, ma c'è motivo di credere che possano essere risolti. Numerose organizzazioni diverse stanno lavorando al problema, incluso il Future of Humanity Institute a Oxford, e il Istituto di ricerca sull'intelligenza artificiale (finanziato da Peter Thiel).

MIRI è interessato in particolare allo sviluppo della matematica necessaria per costruire l'IA amichevole. Se si scopre che è possibile avviare l'intelligenza artificiale di bootstrap, quindi sviluppare questo tipo di La tecnologia "AI amichevole" prima, se ha successo, potrebbe finire per essere l'unica cosa più importante che gli umani abbiano mai fatto.

Pensi che l'intelligenza artificiale sia pericolosa? Sei preoccupato di cosa potrebbe portare il futuro dell'IA? Condividi i tuoi pensieri nella sezione commenti qui sotto!

Crediti immagine: Lwp Kommunikáció Via Flickr, “Rete neurale", Di fdecomite" img_7801“, Di Steve Rainwater,“ E-Volve ”, di Keoni Cabral,“new_20x“, Di Robert Cudmore,“Graffette“, Di Clifford Wallace

Scrittore e giornalista con sede nel sud-ovest, Andre è garantito per rimanere funzionale fino a 50 gradi Celcius ed è impermeabile fino a una profondità di dodici piedi.